算法解剖室,Transformer 架构 10 大创新变体,谁将成为下一个爆款?

在当今的人工智能领域,Transformer架构无疑是一颗耀眼的明星。自它横空出世以来,便以其独特的优势和卓越的性能,深刻地改变了自然语言处理、计算机视觉等众多领域的发展轨迹。随着技术的不断演进,Transformer架构也衍生出了10大创新变体,这些变体在不同的应用场景中展现出了各自的魅力与潜力,让人不禁好奇,谁将成为下一个爆款?

我们来看看这些创新变体都有哪些特点。其中一些变体通过改进注意力机制,提升了模型对长序列数据的处理能力。注意力机制是Transformer架构的核心,它能够让模型自动关注输入序列中的重要部分,从而更好地理解和处理信息。改进后的注意力机制能够更精准地捕捉序列中的语义关系,使得模型在处理长文本时不再出现信息丢失或混淆的情况。

还有一些变体则致力于提高模型的计算效率。在实际应用中,Transformer架构的计算量较大,这限制了它在一些资源受限场景下的应用。为了解决这个问题,研究人员提出了各种优化方法,如减少参数数量、采用更高效的计算架构等。这些创新使得Transformer架构在保持高性能的能够更快地运行,从而满足实时性要求较高的应用场景。

一些变体针对特定的应用领域进行了定制化设计。例如,在计算机视觉领域,研究人员将Transformer架构与卷积神经网络相结合,充分发挥两者的优势,提升了图像识别的准确率和效率。这种跨领域的融合创新为Transformer架构开辟了新的应用空间,使其能够在更多的领域中大放异彩。

那么,在这10大创新变体中,谁最有可能成为下一个爆款呢?这很难给出一个确定的答案,因为每个变体都有其独特的优势和适用场景。从目前的研究趋势和应用需求来看,有几个变体具有较大的潜力。

其中一个备受关注的变体是基于位置编码改进的Transformer。位置编码是Transformer架构中用于表示序列中元素位置的重要部分。改进后的位置编码能够更好地捕捉序列中的位置信息,使得模型在处理序列时能够更加准确地理解元素之间的相对位置关系。这种改进在处理一些需要精确位置信息的任务中,如机器翻译、文本摘要等,具有明显的优势。

另一个有潜力的变体是采用轻量化设计的Transformer。随着移动设备和边缘计算的快速发展,对模型轻量化的需求越来越高。轻量化的Transformer变体通过减少参数数量、优化计算结构等方式,在保持一定性能的前提下,大大降低了模型的计算量和存储需求。这使得它能够在资源受限的设备上快速运行,为智能终端的应用提供了有力支持。

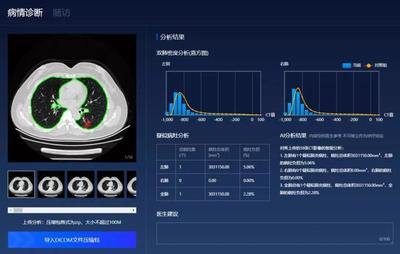

针对特定领域优化的Transformer变体也有望成为爆款。例如,在医疗领域,Transformer架构可以用于分析医学图像、处理病历文本等。通过对医疗数据的深入学习和理解,能够为医生提供辅助诊断和治疗建议。随着医疗行业数字化转型的加速,这种定制化的Transformer变体将有着广阔的应用前景。

Transformer架构的10大创新变体为人工智能的发展注入了新的活力。虽然很难预测谁将成为下一个爆款,但这些变体都在各自的领域中展现出了巨大的潜力。未来,随着技术的不断进步和应用场景的不断拓展,相信会有更多优秀的Transformer变体涌现出来,推动人工智能技术迈向新的高度。我们拭目以待,见证这些创新变体在人工智能舞台上绽放出更加耀眼的光芒。